前言 前段时间写过一篇 gRPC 的入门文章,在最后还留了一个坑没有填:gRPC 的负载均衡问题,因为当时的业务请求量不算大,再加上公司没有对 Istio 这类服务网格比较熟悉的大牛,所以我们也就一直拖着没有解决,依然只是使用了 kubernetes 的 service 进行负载,好在也没有出什么问题。

由于现在换了公司后也需要维护公司的服务网格服务,结合公司内部对 Istio 的使用现在终于不再停留在理论阶段了。

所以也终有机会将这个坑填了。

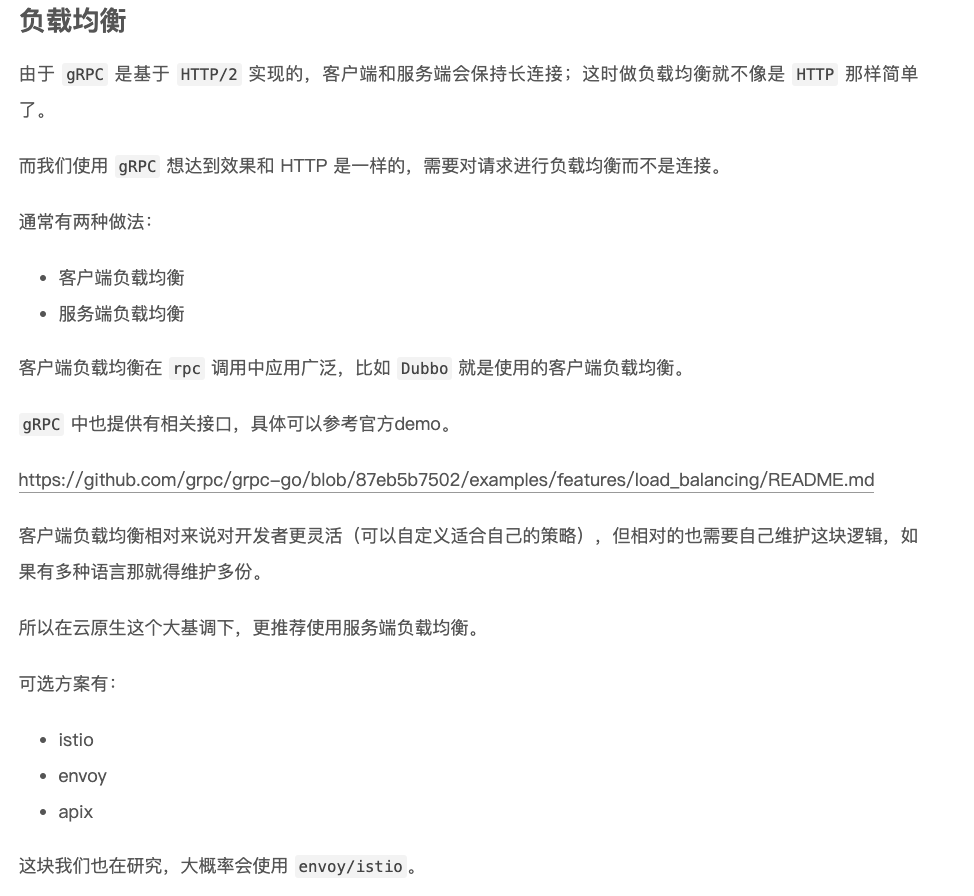

gRPC 负载均衡 负载不均衡 原理 先来回顾下背景,为什么会有 gRPC 负载不均衡的问题。gRPC 是基于 HTTP/2 协议的,所以客户端和服务端会保持长链接,一旦链接建立成功后就会一直使用这个连接处理后续的请求。

除非我们每次请求之后都新建一个连接,这显然是不合理的。

所以要解决 gRPC 的负载均衡通常有两种方案:

服务端负载均衡

客户端负载均衡gRPC 这个场景服务端负载均衡不是很合适,所有的请求都需要经过一个负载均衡器,这样它就成为整个系统的瓶颈,所以更推荐使用客户端负载均衡。

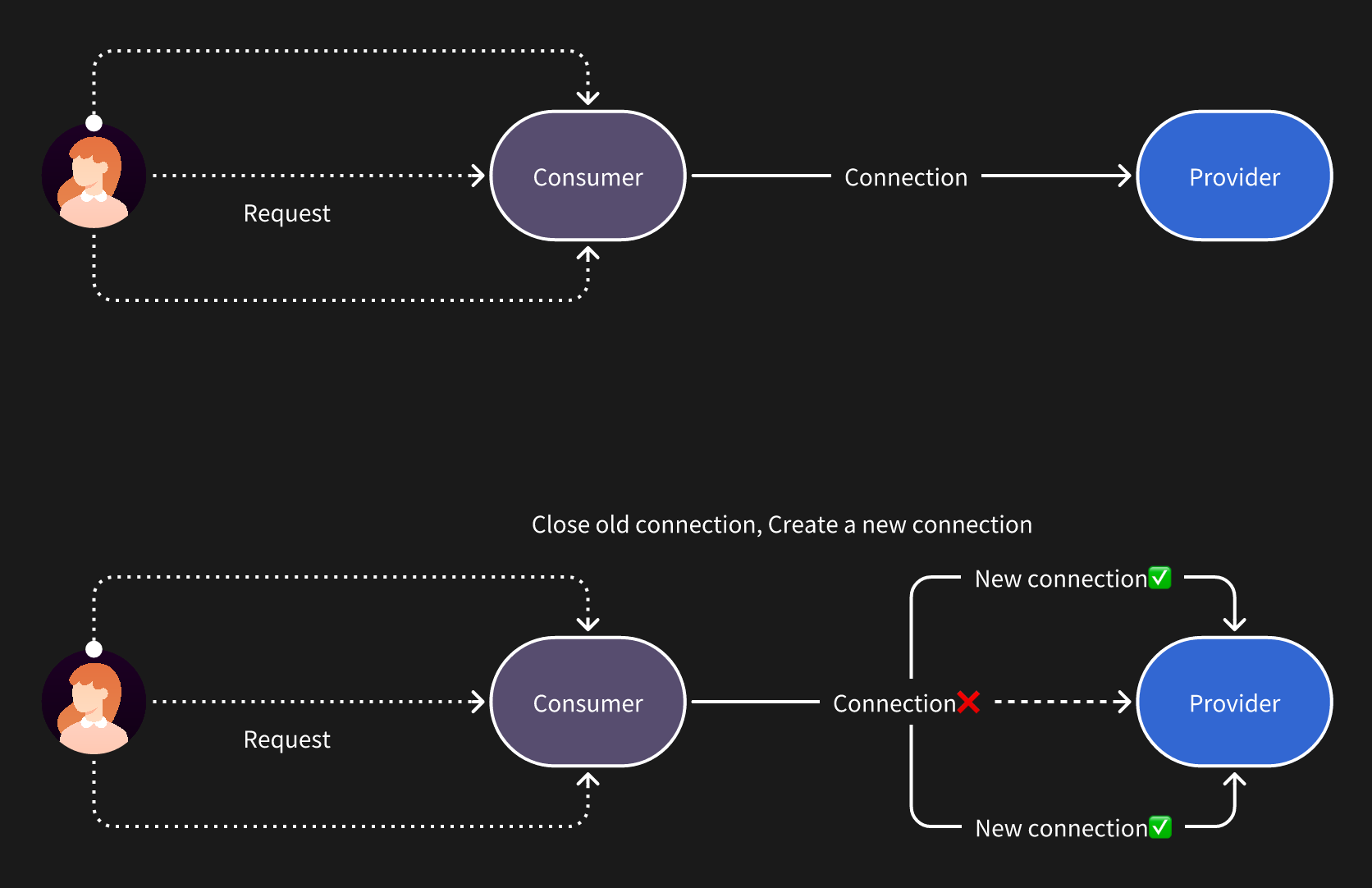

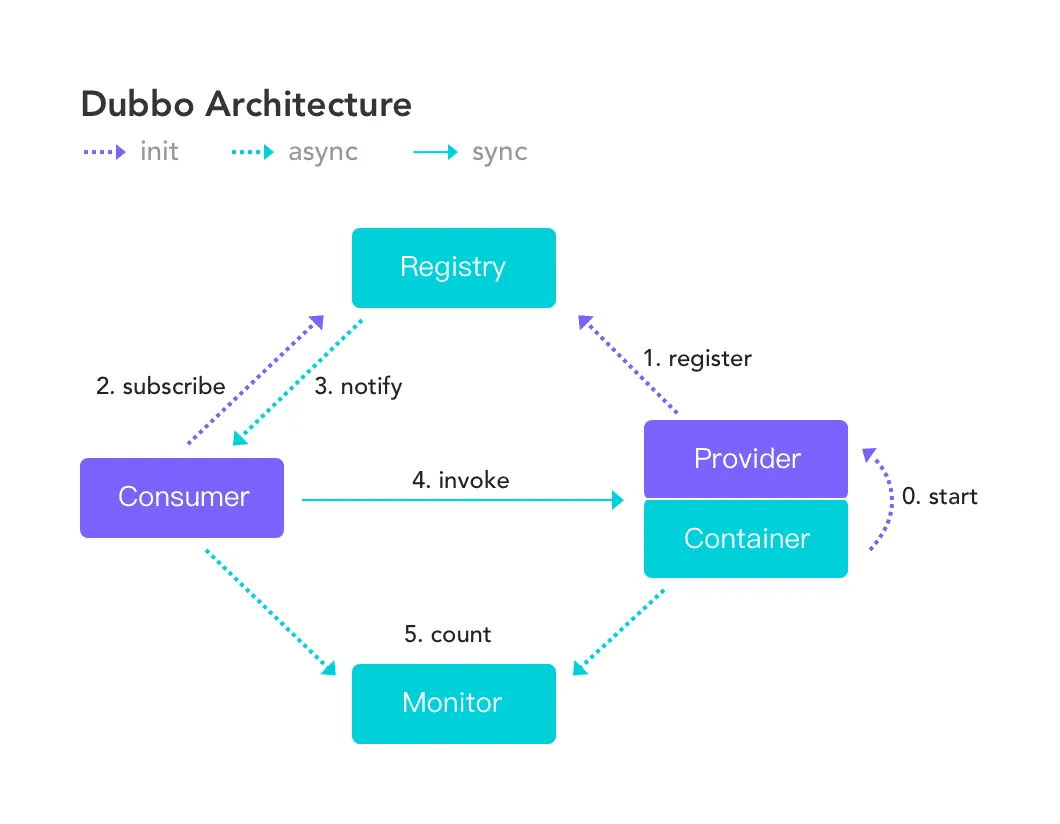

客户端负载均衡目前也有两种方案,最常见也是传统方案。

换成 gRPC 也是类似的,这里以 go-zero 负载均衡的原理为例:

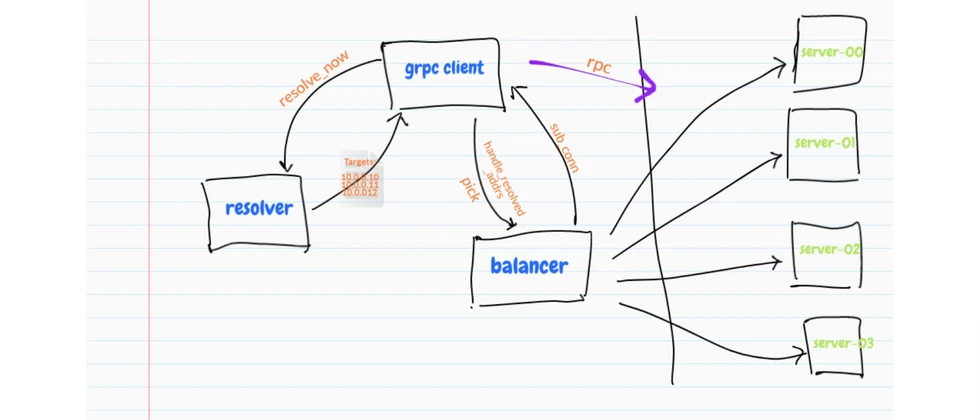

gRPC 官方库也提供了对应的负载均衡接口,但我们依然需要自己维护服务列表然后在客户端编写负载均衡算法,这里有个官方 demo:

https://github.com/grpc/grpc-go/blob/87eb5b7502493f758e76c4d09430c0049a81a557/examples/features/load_balancing/client/main.go

但切换到 kubernetes 环境中时再使用以上的方式就不够优雅了,因为我们使用 kubernetes 的目的就是不想再额外的维护这个客户端包,这部分能力最好是由 kubernetes 自己就能提供。

但遗憾的是 kubernetes 提供的 service 只是基于 L4 的负载,所以我们每次请求的时候都只能将请求发往同一个 Provider 节点。

测试 这里我写了一个小程序来验证负载不均衡的示例:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 go func () var port = ":50051" "tcp" , port) if err != nil { "failed to listen: %v" , err) if err := s.Serve(lis); err != nil { "failed to serve: %v" , err) else { "served on %s \n" , port) type server struct { func (s *server) error ) { "Received: %v" , in.GetName()) return &pb.HelloReply{Message: fmt.Sprintf("hostname:%s, in:%s" , name, in.Name)}, nil

使用同一个 gRPC 连接发起一次 gRPC 请求,服务端会返回它的 hostname

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 var ( "/grpc_client" , func (w http.ResponseWriter, r *http.Request) func () "name" ) "%s:50051" , service), grpc.WithInsecure(), grpc.WithBlock()) if err != nil { "did not connect: %v" , err) "world" defer cancel() if err != nil { "could not greet: %v" , err) "Greeting: %s" , g.GetMessage()))

创建一个 service 用于给 gRPC 提供域名:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 apiVersion: v1 kind: Service metadata: name: native-tools-2 spec: selector: app: native-tools-2 ports: - name: http port: 8081 targetPort: 8081 - name: grpc port: 50051 targetPort: 50051

同时将我们的 gRPC server 部署三个节点,再部署了一个客户端节点:

1 2 3 4 5 6 ❯ k get pod

我们进入客户端节点执行多次 grpc 请求:

1 2 3 4 5 6 7 8 9 k exec -it native-tools-65c5bd87fc-2fsmc bashin :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2in :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2in :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2in :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2in :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2in :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2in :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2in :worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2

会发现每次请求的都是同一个节点 native-tools-2-d6c454689-zpwxt,这也就证明了在 kubernetes 中直接使用 gRPC 负载是不均衡的,一旦连接建立后就只能将请求发往那个节点。

使用 Istio Istio 可以拿来解决这个问题,我们换到一个注入了 Istio 的 namespace 下还是同样的 代码,同样的 service 资源进行测试。

关于开启 namespace 的 Istio 注入会在后续更新,现在感兴趣的可以查看下官方文档:https://istio.io/latest/docs/setup/additional-setup/sidecar-injection/

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 Greeting: hostname:native-tools-2-5fbf46cf54-5m7dl, in:worldistio-proxy@n:/$ curl http://127.0.0.1:8081/grpc_client?name=native-tools-2

可以发现同样的请求已经被负载到了多个 server 后端,这样我们就可以不再单独维护一个客户端 SDK 的情况下实现了负载均衡。

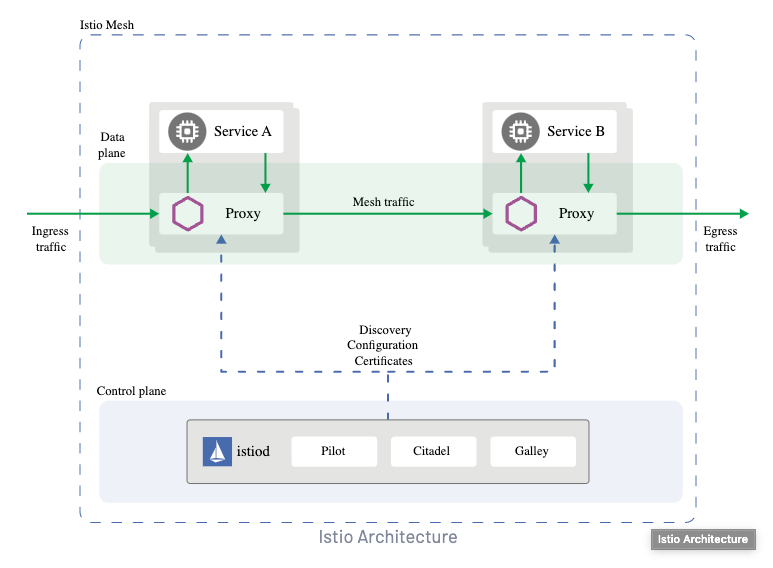

原理 其实本质上 Istio 也是客户端负载均衡的一种实现。

每一个 Pod 下会新增一个 Proxy 的 container,所有的流量入口和出口都会经过它。

它会从控制平面 Istiod 中拿到服务的注册信息,也就是 kubernetes 中的 service。

发生请求时由 proxy 容器中的 Envoy 进行最终的负载请求。

可以在使用了 Istio 的 Pod 中查看到具体的容器:

1 2 3 ❯ k get pod native-tools-2-5fbf46cf54-5m7dl -n istio-test-2 -o json | jq '.spec.containers[].name' "istio-proxy" "native-tools-2"

可以发现这里存在一个 istio-proxy 的容器,也就是我们常说的 sidecar,这样我们就可以把原本的 SDK 里的功能全部交给 Istio 去处理。

总结 当然 Istio 的功能远不止于此,比如:

统一网关,处理东西、南北向流量。

灰度发布

流量控制

接口粒度的超时配置

自动重试等

这次只是一个开胃菜,更多关于 Istio 的内容会在后续更新,比如会从如何在 kubernetes 集群中安装 Istio 讲起,带大家一步步使用好 Istio。

本文相关源码:https://github.com/crossoverJie/k8s-combat

参考链接: